Nvidia 與一系列科技合作夥伴攜手合作,開發了一款具有突破性的軟體,預計能將旗艦 H100 Tensor Core GPU 的性能提升一倍。這款名為 TensorRT-LLM 的開放源碼更新預計在未來幾週內發布,該系統的最新版本在性能上超越了 A100,達到了八倍的提升,而之前 H100 只能達到四倍的性能提升。這一測試是在 GPT-J 6B 上進行的,該模型被用於摘要 CNN 和 Daily Mail 的文章。

在 Meta 的 Llama2 LLM 上進行測試時,搭載 TensorRT-LLM 的 H100 GPU 在更新前比 A100 GPU 的性能提升了 4.6 倍,而更新後則提升了 2.6 倍。

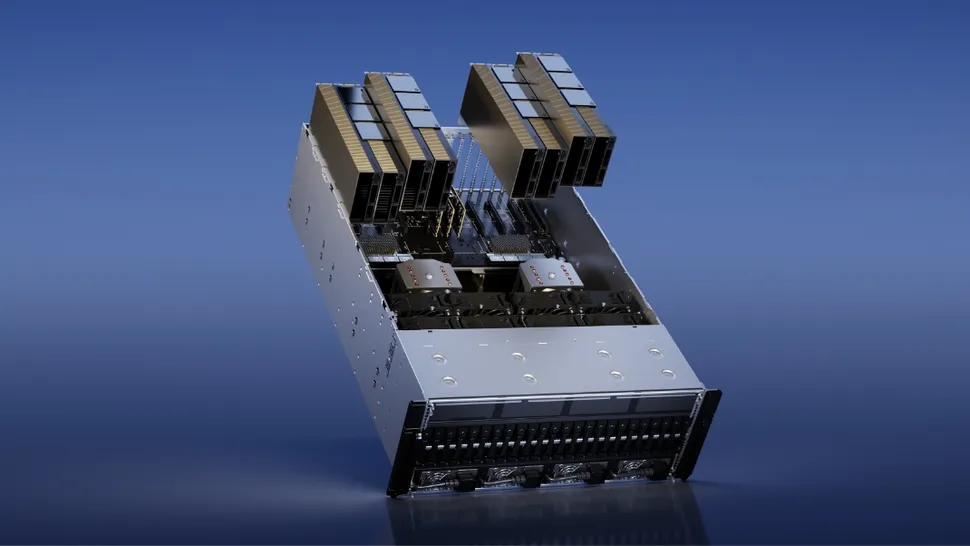

Nvidia H100 GPU 的性能再度提升

大型語言模型的多樣性和動態性使得批量請求並行執行變得困難,這意味著一些請求的完成時間比其他請求更早。為了解決這個問題,Nvidia 與其合作夥伴將 TensorRT-LLM 嵌入了一種更強大的調度技術,稱為 in-flight batching。這種技術利用了文本生成可以分解為多個子任務的特點。

簡單來說,系統在處理下一個請求之前,不需要等待一個請求的整個批量任務完成,而是可以同時處理來自不同請求的新批量任務。TensorRT-LLM 包括 TensorRT 深度學習編譯器,並且包含了優化的核心、預處理和後處理步驟,以及多 GPU 和多節點通信原語。

結果 Nvidia 的 GPU 在性能上取得了突破性的成果,為新的大型語言模型實驗、快速定制和最佳性能鋪平了道路。這款軟體使用了張量平行處理技術,將個別權重矩陣分散在多個設備上,從而實現了高效的推論;每個模型在多個 GPU 和多個伺服器上並行運行。

TensorRT-LLM 還包括了 Llama 2、GPT-2、GPT-3 以及 Falcon、Mosaic MPT、BLOOM 等數十種熱門語言模型的完全優化和可直接運行的版本。這些模型可以通過 Python API 進行訪問。該更新版本已提供早期訪問,並將很快整合到 Nvidia NeMo 框架中,該框架是 Nvidia AI Enterprise 的一部分。研究人員可以通過 NeMo 框架、NGC 門戶或 GitHub 上的源代碼庫進行訪問。